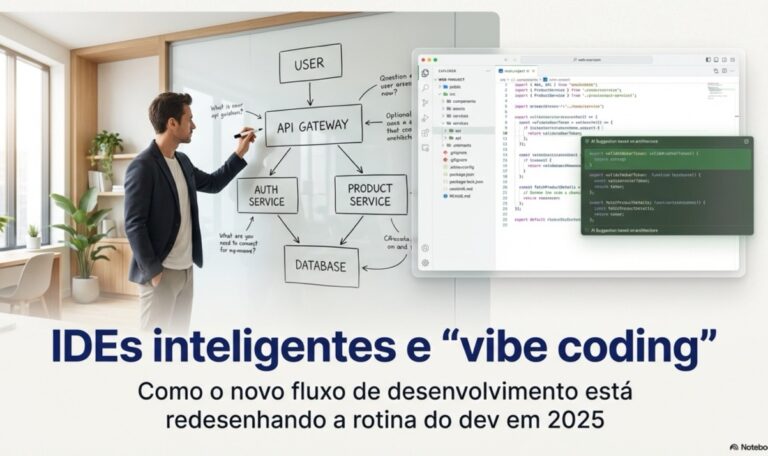

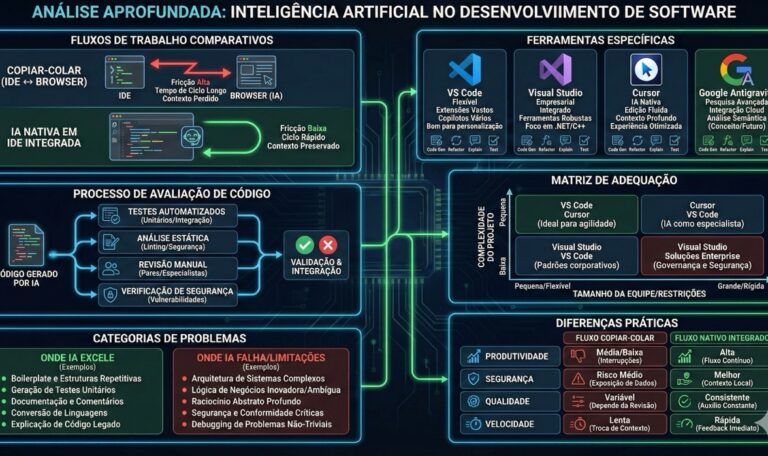

Introdução com gancho claro Em 2025, o desenvolvedor não está apenas escolhendo framework: está escolhendo qual “cérebro auxiliar” vai pilotar o fluxo de trabalho inteiro, do primeiro commit ao deploy. IDEs com geração de código contextual, debugging preditivo e ferramentas de vibe coding como Bolt, Lovable e Cursor deixaram de ser curiosidade para virar parte da stack séria de times que precisam entregar rápido sem perder controle técnico. No meio disso, surge a pergunta incômoda que todo dev faz, mesmo que em silêncio: o que ainda é “habilidade humana” nesse novo pipeline – e onde está a vantagem competitiva de quem escreve software?. Este artigo parte dessa tensão para analisar o novo ecossistema de desenvolvimento orientado a IDEs inteligentes e vibe coding, com foco no que muda na arquitetura, nas práticas de time e nas decisões de carreira para os próximos anos. Do editor de texto ao ambiente “autônomo” Durante anos, a conversa sobre ferramentas se resumia a “VS Code, JetBrains ou outro editor favorito”, com extensões incrementais de produtividade. Em 2025, o cenário é outro: IDEs passam a funcionar como plataformas completas, que entendem contexto de projeto, sugerem refactors em larga escala e apontam gargalos futuros na arquitetura, integrando-se com pipelines de CI/CD e ferramentas serverless desde o início. Ferramentas como GitHub Copilot, Tabnine e assistentes especializados evoluíram de “auto-complete esperto” para agentes que sugerem estruturas de componentes, testes e até ajustes de performance baseados em padrões do próprio repositório. O resultado é um salto de produtividade em tarefas repetitivas, mas também um risco claro: times que terceirizam decisões de design para o assistente criam dívidas que só aparecem meses depois, em forma de complexidade acoplada e bugs difíceis de reproduzir. Vibe coding: o dev pilotando por alto nível Em paralelo, surgem as plataformas de vibe coding, como Bolt, Lovable e Cursor, que prometem “conversar com o sistema” em vez de apenas editar arquivos. A lógica é simples: o desenvolvedor descreve funcionalidades, regras de negócio e ajustes desejados em linguagem natural, enquanto a plataforma orquestra geração de código, criação de arquivos, configuração de rotas, testes básicos e até chamadas de API. Isso aproxima o fluxo de desenvolvimento da forma como o negócio pensa o produto: em termos de intenções, e não de detalhes de implementação. Mas há um efeito colateral estratégico: quem não domina fundamentos de arquitetura, segurança e performance tende a aceitar propostas de código sem conseguir avaliar o impacto a médio prazo, gerando sistemas que “funcionam hoje” e colapsam ao crescer. Trecho em destaque:O verdadeiro diferencial não está em quem usa IDE inteligente, mas em quem sabe dizer “não” para o código sugerido. Impacto direto na rotina dos times Na prática, a adoção desses ambientes inteligentes está mudando a composição e a dinâmica das squads de desenvolvimento. Tarefas antes distribuídas entre juniors e plenos – como escrever boilerplate, montar endpoints padrão ou configurar pipelines – passam a ser automatizadas, enquanto cresce a demanda por perfis capazes de desenhar arquitetura evolutiva, revisar decisões de alto nível e negociar trade-offs com o negócio. Algumas consequências que já aparecem em 2025: Essa mudança casa com projeções de mercado que apontam crescimento contínuo da demanda por desenvolvedores, mas com um deslocamento de valor: menos foco em “mão que digita” e mais em visão sistêmica, governança e responsabilidade sobre o ciclo de vida do software. Arquitetura moderna na era das IDEs inteligentes Enquanto a discussão pública ainda gira em torno de ferramentas, nos bastidores quem está se beneficiando de verdade são os times que conectam esse novo fluxo a arquiteturas modernas. O uso de serverless, microsserviços bem delimitados, APIs consistentes e frameworks enxutos (como FastAPI no ecossistema Python ou stacks web modernas com PWAs e funções em nuvem) cria um terreno fértil para automação segura, com limites claros. Nesse contexto, as IDEs inteligentes funcionam como multiplicador: ajudam a padronizar endpoints, gerar contratos de API, produzir testes automatizados e manter documentação viva a partir do próprio código. Em contrapartida, arquiteturas monolíticas mal documentadas tendem a “confundir” os assistentes, que começam a sugerir remendos em vez de melhorias estruturais – um problema que se agrava na medida em que o time confia demais nas sugestões. O que isso significa para o desenvolvedor brasileiro Para o desenvolvedor brasileiro – especialmente fora dos grandes centros –, esse movimento tem duas leituras opostas. De um lado, o acesso a ferramentas de alto nível reduz a barreira de entrada para projetos complexos, permitindo que times menores em mercados regionais entreguem soluções com qualidade equivalente a players globais. De outro, a concorrência também se globaliza ainda mais: se a camada de “produção de código” é parcialmente comoditizada, empresas tendem a buscar profissionais que somem visão de produto, domínio de negócio e capacidade de conduzir decisões difíceis em ambientes incertos. Para quem insiste em ficar restrito a “stack da moda” e atalhos de geração automática, o risco é virar recurso substituível em um mercado que está, simultaneamente, carente de talento qualificado e saturado de perfis superficiais. Em 2025, escrever código rápido é básico; raro é quem sabe dizer o que não deve ser construído. Imagem de capa sugerida Descrição sugerida para a capa:“Tela de IDE moderna exibindo um projeto web com painel lateral de sugestões inteligentes, sobreposta a um desenvolvedor analisando diagramas de arquitetura em um quadro branco, em ambiente de escritório clean e minimalista.” Essa composição conecta visualmente a ideia de automação no editor com a responsabilidade humana na decisão arquitetural, reforçando o tom editorial do artigo. Conclusão: produtividade sem direção é ruído A nova geração de IDEs inteligentes e plataformas de vibe coding não é uma revolução neutra: está redesenhando quem tem poder de decisão dentro dos times de desenvolvimento. Times que tratam essas ferramentas como “atalho para entregar qualquer coisa mais rápido” tendem a acumular dívidas técnicas silenciosas, que mais tarde cobram juros em performance, segurança e custo operacional. O movimento mais lúcido para os próximos anos não é resistir às ferramentas, nem abraçá-las sem filtro, mas reposicionar o papel do desenvolvedor como curador crítico de..