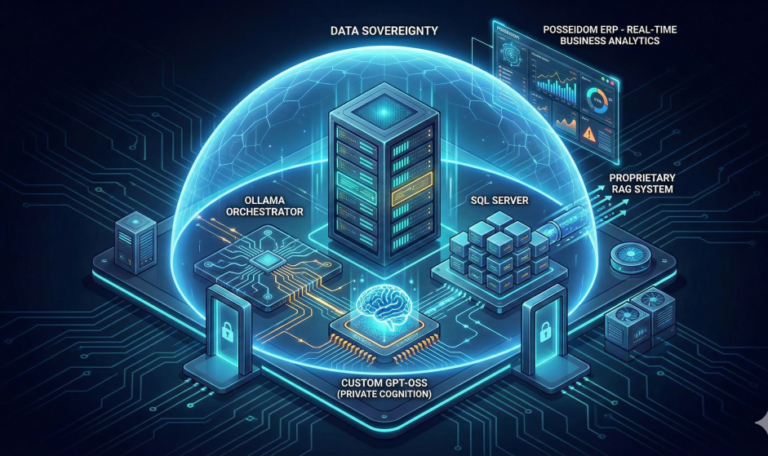

Introdução: O Novo Paradigma de IA nos Sistemas ERP A adoção de inteligência artificial generativa em sistemas corporativos representa uma transformação sem precedentes na forma como as organizações processam informações, automatizam decisões e extraem valor estratégico de seus dados. No entanto, para empresas que lidam com informações sensíveis e operam sob regimes regulatórios rigorosos, a dependência de serviços de nuvem pública tem sido historicamente um obstáculo insuperável. Foi diante desse desafio que nossa empresa desenvolveu o Posseidom, um ERP web proprietário que incorpora tecnologia de IA generativa de ponta mantendo integralmente o controle sobre os dados e a infraestrutura. Esta solução inovadora combina três pilares tecnológicos distintivos: o Ollama como orquestrador inteligente de modelos de linguagem, um GPT-OSS customizado executado em nosso data-center privado, e um sistema RAG (Retrieval-Augmented Generation) proprietário integrado diretamente ao SQL Server. Esta arquitetura on-premise representa não apenas uma resposta técnica a restrições de segurança, mas uma escolha estratégica que posiciona nossa organização na vanguarda da computação corporativa autônoma, demonstrando que é possível conciliar inovação disruptiva com governança de dados intransigente. O Papel do Ollama: Orquestração Eficiente e Escalável de Modelos de Linguagem O Ollama funciona como o cérebro de coordenação de nossa infraestrutura de IA, atuando como uma camada de abstração sofisticada entre as aplicações do Posseidom e os modelos de linguagem propriamente ditos. Em termos práticos, imagine-o como um maestro de uma orquestra sinfônica: cada músico representa um modelo de linguagem com capacidades específicas, e o Ollama garante que todos executem em perfeita sincronia, no momento certo e com os recursos adequados. Sua principal função é gerenciar o ciclo de vida completo dos modelos, desde o carregamento e descarregamento em GPU até a distribuição inteligente de requisições de acordo com a carga de trabalho e prioridade. Quando um usuário do Posseidom solicita uma análise preditiva de demanda de estoque, por exemplo, o Ollama avalia instantaneamente qual modelo está melhor posicionado para responder, considerando fatores como latência atual, especialidade do modelo e disponibilidade de recursos computacionais. A implementação do Ollama em nosso ambiente on-premise proporciona uma flexibilidade que serviços gerenciados em nuvem raramente oferecem. Podemos implantar múltiplas versões do mesmo modelo para diferentes departamentos, cada uma com fine-tuning específico, sem incorrer em custos adicionais de instância. A camada de orquestração inclui mecanismos de cache sofisticados que armazenam embeddings e respostas frequentes diretamente na memória volátil do servidor, reduzindo o tempo de resposta em até 70% para consultas repetidas. Além disso, o Ollama gerencia automaticamente a quantização de modelos, adaptando a precisão numérica (de FP16 a INT4) conforme a demanda por memória VRAM, permitindo que executemos modelos robustos mesmo em hardware com capacidade limitada. Esta capacidade de otimização dinâmica garante que o Posseidom mantenha responsividade consistente mesmo durante picos de utilização, como fechamento fiscal ou campanhas promocionais de alto volume, quando centenas de usuários simultaneamente acionam funcionalidades baseadas em IA. GPT-OSS Personalizado: Inteligência Especificamente Treinada para Nosso Ecossistema O GPT-OSS customizado representa o coração cognitivo do Posseidom, um modelo de linguagem open-source que foi meticulosamente adaptado para compreender profundamente os domínios específicos de nossa operação empresarial. Diferente de modelos genéricos disponíveis publicamente, nossa versão foi submetida a um processo extensivo de fine-tuning utilizando nossos próprios dados corporativos anonimizados, incluindo padrões de fluxo de trabalho, nomenclaturas de produtos, estruturas organizacionais e históricos de decisões comerciais. Este treinamento especializado transforma o modelo de um conhecimento amplo mas superficial em um especialista corporativo capaz de interpretar contextos únicos da nossa realidade. Quando o sistema processa uma solicitação de análise de margem de contribuição por linha de produto, por exemplo, ele não apenas executa cálculos matemáticos, mas compreende as particularidades de nossa estrutura de custos indiretos, políticas de desconto comercial e critérios de alocação de despesas administrativas. A execução deste modelo em nosso data-center privado segue uma arquitetura de implantação em contêineres Docker gerenciados por Kubernetes, garantindo alta disponibilidade e escalabilidade horizontal. Cada instância do modelo opera em isolamento de namespaces, com quotas de recursos rigorosamente definidas para evitar que processamentos intensivos comprometam a estabilidade de outras aplicações críticas. Implementamos um pipeline MLOps interno que permite atualizar o modelo com novos dados de treinamento mensalmente, mantendo sua relevância à medida que nossos processos evoluem. A segurança do modelo é assegurada por múltiplas camadas: criptografia em repouso para os pesos do modelo, autenticação mútua TLS entre serviços e auditoria completa de todas as inferências realizadas. Esta abordagem garante que nossa propriedade intelectual incorporada ao modelo permaneça completamente sob nosso controle, sem risco de vazamento por meio de APIs de terceiros ou armazenamento em infraestrutura externa. Arquitetura RAG: Conectando IA Generativa ao SQL Server Corporativo O sistema RAG (Retrieval-Augmented Generation) customizado constitui a inovação mais disruptiva do Posseidom, pois resolve o problema fundamental da amnésia de modelos de linguagem: sua incapacidade de acessar informações corporativas atualizadas em tempo real. Nossa implementação consiste em três componentes principais: o vetorizador de documentos, o mecanismo de busca semântica e o integrador SQL. O vetorizador processa continuamente nosso banco de dados SQL Server, convertendo não apenas textos documentais, mas também dados estruturados como tabelas de clientes, registros de transações e metadados de processos em embeddings numéricos de alta dimensionalidade. Esses vetores são armazenados em um banco de vetores (vector database) local baseado em HNSW (Hierarchical Navigable Small World), uma estrutura de dados que permite busca de similaridade em milissegundos mesmo em coleções com milhões de vetores. Quando um usuário solicita ao Posseidom uma análise como “quais clientes apresentaram maior variação no prazo de pagamento nos últimos seis meses?”, o modelo não precisa “adivinhar” com base em dados estáticos de treinamento. O sistema RAG intercepta a consulta, gera embeddings da pergunta, realiza busca vetorial nos dados financeiros recentes do SQL Server, recupera os registros relevantes (faturas, pagamentos, contatos comerciais) e os injeta no contexto do prompt do GPT-OSS. O resultado é uma resposta que combina o poder de geração de linguagem natural do modelo com precisão factual derivada de nossos dados operacionais em tempo real. A integração com o SQL Server é realizada via SQL Server..