Fluxos de Trabalho Comparativos

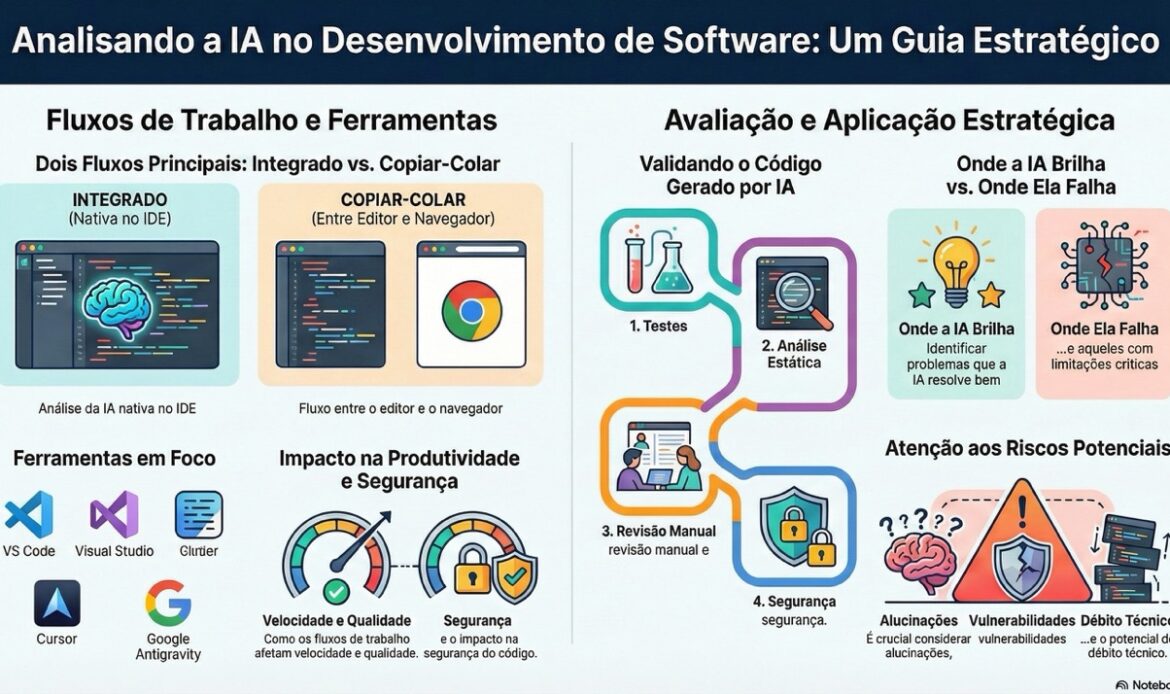

Fluxo “Copiar-Colar” (IDE ↔ Browser): Neste modo clássico, o desenvolvedor alterna entre o editor de código e uma ferramenta de IA no navegador (ex: ChatGPT). Tipicamente, pede-se ao chatbot para gerar ou corrigir código, copia-se a resposta para a IDE, executa-se ou compila-se o código, e então erros ou ajustes necessários são copiados de volta para o chatbotmedium.com. Este ciclo se repete para cada iteração. Embora funcional, esse fluxo tem pontos de fricção: muita troca de contexto (sair da IDE, copiar e colar texto), risco de perder sincronia com o estado atual do código e limitação de contexto (é preciso fornecer manualmente trechos relevantes ao prompt). Por outro lado, a natureza mais lenta e manual desse processo força o desenvolvedor a inspecionar criticamente o código gerado, promovendo maior entendimento. De fato, alguns acham que essa interação deliberada encoraja mais reflexão sobre o código sugeridomedium.com.

Fluxo com IA Integrada na IDE: Aqui a IA está incorporada diretamente no editor (por exemplo, GitHub Copilot ou chat integrado no VS Code/Visual Studio). O programador pode invocar sugestões de código em tempo real enquanto digita ou solicitar refatorações e explicações via comandos ou chat dentro da IDE. As edições propostas são aplicadas diretamente nos arquivos abertos, muitas vezes com visualização de diffs antes de aceitar mudançaslearn.microsoft.com. Esse fluxo reduz drasticamente o tempo de ciclo de cada iteração – não há necessidade de copiar nada manualmente, e a IA pode “ver” mais facilmente o contexto do código circundante. Por exemplo, em projetos grandes, um assistente na IDE consegue acessar o projeto inteiro ou usar ferramentas do editor para navegar, algo impraticável via copiar-colarlinkedin.com. Os pontos de fricção aqui tendem a ser menores: a integração é mais suave e contínua, mantendo o foco no código. Uma possível desvantagem é a sensação de “mágica” excessiva – a IA aplica mudanças rapidamente e o desenvolvedor pode aceitá-las sem compreender totalmente, o que levanta preocupações sobre aprendizado e controle do códigomedium.com. Em resumo, o fluxo nativo na IDE oferece mais agilidade e menos interrupções, mas exige disciplina do usuário para revisar ativamente as sugestões (já que a facilidade pode mascarar problemas).

Ferramentas Específicas (VS Code, Visual Studio, Cursor, Antigravity)

Visual Studio Code (VS Code) com IA: O VS Code tornou-se um dos ambientes mais populares para integrar assistentes de código. A principal solução é o GitHub Copilot, uma extensão oficial que fornece autocompletar avançado e um chat contextual dentro do editordaily.dev. Com Copilot, o desenvolvedor recebe sugestões inline enquanto digita e pode abrir uma janela lateral de chat para fazer perguntas ou gerar trechos maiores de código. A integração é bastante natural – por exemplo, Copilot pode sugerir automaticamente a próxima linha ou bloco de código com base no contexto atual, atuando como um “auto-completar turbinado”itecsonline.com. Há também extensões de terceiros (como CodeGPT, Tabnine, etc.) que ampliam as capacidades de IA no VS Code. Em termos de experiência, o VS Code oferece flexibilidade: o usuário pode aceitar, editar ou ignorar sugestões rapidamente, e a IA se adapta ao contexto do arquivo aberto (suportando múltiplas linguagens). Uma limitação é o tamanho do contexto – modelos padrão podem não ver o projeto inteiro, apenas partes relevantes, requerendo possivelmente dividir pedidos complexos. Ainda assim, a vantagem principal é a produtividade: estudos mostram que ferramentas como Copilot podem acelerar tarefas de codificação individuais (há relatos de desenvolvedores completando tarefas ~55% mais rápido em média) – embora o impacto real dependa da revisão cuidadosa do código gerado. Outra vantagem é a familiaridade: VS Code permanece o mesmo editor, apenas enriquecido com sugestões; não há necessidade de aprender uma IDE nova. Por fim, para equipes, o Copilot possui uma versão enterprise com melhor suporte a compliance (logs de uso, políticas de exclusão de conteúdo, etc.), o que facilita adoção em empresas maioresitecsonline.comitecsonline.com.

Visual Studio (IDE) com IA: O Visual Studio (focado em .NET, C++ e outras plataformas Windows) também incorpora o GitHub Copilot e funcionalidades de IA similares. A experiência é análoga à do VS Code em termos de Copilot Chat e sugestões inline, porém dentro do ecossistema Visual Studio. Por exemplo, o Copilot Chat pode ser usado tanto numa janela de chat quanto inline no editor de código, exibindo diffs aplicáveis que o desenvolvedor pode aprovar ou rejeitarlearn.microsoft.comlearn.microsoft.com. Além do Copilot, a Microsoft já possuía o IntelliCode, que usa inteligência para recomendações de código baseadas em padrões de projetos open-source, embora isso seja bem mais simples comparado a LLMs. Em capacidades, o Visual Studio com Copilot suporta geração de código, explicação de trechos, geração de testes e até sugestão de mensagens de commit ou análise de diffs, tudo integrado à IDE e suas ferramentas de depuraçãolearn.microsoft.comlearn.microsoft.com. A integração com o ecossistema Microsoft é um ponto forte – por exemplo, quem usa Azure DevOps ou repositórios internos pode usufruir do Copilot com autenticação unificada, e as sugestões respeitam a linguagem e framework (.NET) usados no projeto. Em interface, Visual Studio tende a incorporar a IA de forma não intrusiva (sugestões aparecendo em cinza, ou um painel de chat acoplável). A experiência do desenvolvedor aqui é aprimorada por recursos como visualização de onde a sugestão buscou referência em código público (evitando problemas de licença). Quanto a vantagens e limitações: a vantagem é tornar o “pair programming” acessível dentro de uma ferramenta robusta de desenvolvimento corporativo. A limitação pode ser performance – Visual Studio já é pesado e a IA adiciona mais processamento – e contexto restrito (grandes soluções podem exceder o que o modelo consegue analisar de uma vez). Ainda assim, para equipes focadas em tecnologias Microsoft, essa integração poupa tempo e mantém todo o fluxo (desde escrever código até depurar) dentro de um só ambiente.

Cursor (Editor de Código com IA): O Cursor é um editor AI-first emergente, essencialmente um fork do VS Code modificado para potencializar o uso de IAen.wikipedia.orgdaily.dev. Sua premissa é tornar a experiência de programação com IA mais fluida e poderosa. Em termos de capacidades, o Cursor usa modelos avançados (GPT-4, Claude, etc.) para oferecer completações de código, refatorações multi-arquivo e comandos em linguagem natural integrados ao editordaily.devdaily.dev. Por exemplo, o desenvolvedor pode selecionar uma função e simplesmente pedir em inglês: “extraia este código em uma função reutilizável” que o Cursor executará a mudança em todo o projeto. A integração com a interface é profunda: há um painel de chat lateral, atalhos e comandos específicos (como Ctrl+K para descrever mudanças desejadas) e suporte a boa parte das extensões do VS Code, Git, SSH, etc., mantendo um ambiente familiardaily.dev. A experiência de uso relatada é de grande produtividade, especialmente em tarefas repetitivas ou de escopo definido: o Cursor analisa o projeto inteiro para dar sugestões contextuais, consegue gerar funções completas ou arquivos inteiros, e até ajudar na documentação ou correção de bugs comunsdaily.devdaily.dev. Um desenvolvedor relata que o Cursor propôs refatorações “exatamente iguais ao diff que eu aprovaria” – indicando alta precisão em mudanças locais bem definidasblog.stackademic.comblog.stackademic.com. Vantagens: rapidez e contexto ampliado – o Cursor muitas vezes aplica mudanças em segundos que poderiam levar horas manualmente, cobrindo múltiplos pontos no código simultaneamente (ex: atualizar todas as camadas da aplicação após mudar um esquema de banco de dadoslinkedin.com). Além disso, suporta múltiplos modelos de IA, permitindo escolher entre desempenho e qualidadeitecsonline.com. Limitações: por ser relativamente novo, carece de alguns recursos de governança e pode deixar o desenvolvedor “no escuro” quanto ao raciocínio das mudanças. Diferentemente de um chat tradicional que explica cada passo, o Cursor ao usar o recurso Composer aplica transformações e só mostra o resultado final, sem muita explicação das decisões tomadasitecsonline.com. Isso pode ser um problema para rastreabilidade ou quando a modificação é complexa. Há também registros de que, em sessões longas, ele possa “esquecer” partes do contexto ou inserir código em lugares indevidosdaily.dev, exigindo supervisão. Para usos profissionais, outro ponto a considerar é privacidade: o Cursor requer chave de API para modelos como OpenAI/Anthropic, o que significa que o código fonte está sendo enviado a esses serviços de nuvem (similar ao Copilot) – algo a verificar conforme políticas da organização.

Google Antigravity: O Antigravity, anunciado em 2025 pela Google, representa uma abordagem inovadora e “agentiva” ao desenvolvimento assistido por IAdevelopers.googleblog.com. Em vez de apenas sugerir linhas de código, o Antigravity introduz agentes autônomos capazes de realizar tarefas de desenvolvimento de ponta a ponta. Ele combina dois modos de uso: um Editor View (um IDE tradicional com IA – com autocompletar de código e comandos inteligentes) e um Manager Surface, onde o desenvolvedor pode orquestrar e observar múltiplos agentes trabalhando em paralelodevelopers.googleblog.com. Esses agentes podem planejar, executar e verificar tarefas complexas de forma assíncrona, usando diferentes ferramentas – por exemplo, escrever código para uma nova feature, abrir um terminal para rodar a aplicação, e abrir um browser para testar automaticamente a interfacedevelopers.googleblog.com. Tudo isso com mínima intervenção humana, além de validação de resultados. Em termos de capacidades, é o mais abrangente: pode modificar vários arquivos, executar testes, tirar screenshots da aplicação rodando, e iterar conforme feedback. A integração com a interface se dá via o conceito de Artifacts: ao invés de apenas logs de texto, o Antigravity apresenta artefatos visuais (listas de tarefas, planos de implementação, screenshots, gravações de tela) para o desenvolvedor inspecionar o trabalho do agentedevelopers.googleblog.com. Isso serve para construir confiança – o usuário revisa esses artefatos para verificar se a intenção foi atendida e pode comentar neles para orientar o agente, que ajusta seu plano em tempo realdevelopers.googleblog.com. A experiência do desenvolvedor aqui muda de “escrever código diretamente” para “supervisionar e orientar em alto nível”: o objetivo é operar num nível mais abstrato e deixar a execução detalhada para a IA. Por exemplo, em vez de implementar manualmente um novo componente, o dev pede ao agente e recebe evidências de funcionamento (como um vídeo do front-end alterado) para aprovardevelopers.googleblog.com. Vantagens: enorme potencial de aceleração em tarefas multi-etapas (há relatos de o Antigravity reescrever um subsistema inteiro em minutos – trabalho que levaria uma tardeblog.stackademic.com). Ele brilha em tarefas complexas e extensas, que envolvem múltiplas partes (código, configuração, testes) – onde agentes podem explorar soluções em paralelo e validar entre si. Além disso, possui memória de longo prazo via knowledge base, para aprender com as iterações e melhorar em tarefas futurasdevelopers.googleblog.com. Limitações: é uma tecnologia muito recente (ainda em public preview em 2025) e não totalmente comprovada em produção. Implementar agentes autônomos traz desafios de segurança e controle: o desenvolvedor precisa assegurar que o agente não tome ações indesejadas ou inseguros (por isso a ênfase em verificação por artifacts). Do ponto de vista organizacional, faltam ainda certificações e conformidades – por exemplo, o Antigravity não possui atestados de compliance (SOC 2, HIPAA, etc.) no lançamento, o que deixa empresas reguladas cautelosasitecsonline.comitecsonline.com. Em resumo, o Google Antigravity traz um paradigma promissor de trabalhar em um nível orientado a tarefas, indo além do autocompletar tradicional, porém requer maturação. No estado atual, especialistas sugerem experimentá-lo em projetos menores ou protótipos, enquanto se mantém ferramentas consolidadas (como Copilot ou Cursor) para trabalho críticoitecsonline.com.

Processo de Avaliação e Validação de Código Gerado por IA

Garantir a correção, qualidade e segurança do código gerado por IA é fundamental. Uma vez que a IA produz um trecho, o desenvolvedor (e a equipe) devem proceder a uma avaliação criteriosa antes de incorporar esse código. As principais etapas e metodologias incluem:

- Testes Automatizados e Análise Estática: Deve-se começar pelo básico: compilar/executar o código gerado e rodar os testes existentes, além de aplicar ferramentas de análise estática e lintersdocs.github.com. Isso verifica rapidamente se o código funciona e não introduz erros evidentes. Por exemplo, após aceitar uma sugestão de função, rode os testes unitários pertinentes e verifique se todos passam. Em paralelo, use analisadores como SonarQube, ESLint, Pylint, etc., para detectar smells ou violações de padrão. Ferramentas de segurança estática (CodeQL, Dependabot, etc.) também devem ser executadas para identificar vulnerabilidades ou problemas de dependências logo no iníciodocs.github.com.

- Verificação de Contexto e Intenção: Confirme se o código gerado se alinha aos requisitos do projeto e à intenção original. Muitas vezes a IA produz uma solução plausível, porém que não se encaixa perfeitamente na arquitetura ou foge da especificação esperada. É preciso revisar se “o código resolve o problema certo da forma certa?”. Isso inclui checar conformidade com padrões de design da base de código e aderência a convenções do timedocs.github.com. Por exemplo, se a IA gera uma abordagem alternativa para uma funcionalidade, avalie se ela respeita as camadas do sistema ou se introduz suposições indevidas. Nesta fase, é útil consultar a documentação do projeto (README, design docs) e até envolver o próprio assistente de IA no esclarecimento – pedindo, por exemplo: “Explique como este trecho se encaixa na arquitetura existente”. Se a explicação revelar inconsistências, é um sinal de alerta.

- Avaliação da Qualidade do Código: Aspectos de engenharia de software clássicos continuam valendo. Inspecione o código quanto a legibilidade, clareza e manutenibilidadedocs.github.com. Nomes de variáveis e funções fazem sentido? O código está bem estruturado em pequenas unidades ou veio muito monolítico? Comentários ou documentação foram fornecidos quando necessário? Não aceite cegamente código confuso ou excessivamente complexo – muitas vezes é melhor pedir para a IA refatorar ou até escrever manualmente de forma mais simples do que lidar com um bloco obscurodocs.github.com. Uma boa prática é solicitar ao assistente sugestões de melhoria: “Encontre problemas de legibilidade e mantenabilidade neste código” e avaliar as recomendaçõesdocs.github.com. O objetivo é assegurar que, além de funcionar, o código será compreensível e fácil de manter no futuro.

- Auditoria de Dependências e Pacotes: Quando a IA introduzir novas bibliotecas, frameworks ou chamadas de API, seja vigilante. Verifique se os pacotes sugeridos realmente existem e são confiáveis. Há casos em que LLMs “alucinam” nomes de funções ou pacotes que parecem legítimos mas não existem de fatodocs.github.com. Mesmo pacotes reais devem ser checados quanto a manutenção e licença: certifique-se de que não está importando algo abandonado ou incompatível com a licença do seu projeto (por exemplo, evitando inserir um pacote GPL em um projeto permissivo)docs.github.com. Além disso, mantenha atenção para possíveis supply chain attacks: se a IA sugerir usar uma biblioteca estranha para uma funcionalidade trivial, melhor desconfiar. Em suma, verifique manualmente cada dependência nova – inclusive rodando

npm audit/pip checketc., se aplicável, e confirmando que a versão é segura. - Identificação de “Pegadinhas” Específicas de IA: Ferramentas de IA podem cometer erros não humanos sutis, portanto desenvolva um olhar crítico para esses pitfalls. Exemplos comuns: utilização de APIs ou funções inexistentes (a IA confunde com algo parecido), lógica incorreta apesar de parecer plausível, ou ignorar restrições explícitas do problemadocs.github.com. Também observe se o código gerado silenciou problemas em vez de resolvê-los – por exemplo, marcar um teste falhando como skipped ao invés de corrigir a falhadocs.github.com. Caso a IA sugira deletar código de teste ou ignorar validações, isso deve acender um alerta imediato. Nessas situações, vale a pena perguntar ao assistente: “Por que você removeu tal trecho? Existe alternativa sem remover?”docs.github.com. Manter uma postura cética (confiar desconfiando) ajuda a pegar deslizes onde o código “parece bom” mas na verdade não faz exatamente o que deveria.

- Revisão por Pares e Supervisão Humana: Mesmo com testes automatizados, é importante envolver desenvolvedores na revisão. Se o trecho gerado pela IA for complexo, crítico ou de segurança sensível, faça um code review humano antes de mesclardocs.github.com. Compartilhe o código gerado com colegas, explicando o objetivo, e avaliem juntos se atende aos critérios de definição de pronto. Um segundo par de olhos pode detectar uma implicação que passou despercebida. Além disso, times estão criando checklists específicas para revisão de código de IA – cobrindo itens como “Verificou-se vulnerabilidades conhecidas? O código segue nossos padrões de logging/erro? Não expõe dados sensíveis?”docs.github.com. Essa colaboração humana assegura que a IA seja uma ajuda e não um risco.

- Automação de Verificação no Pipeline: Integre controles de qualidade no fluxo de CI/CD para código gerado por IA assim como para código humano. Configure etapas automatizadas que rodem linters, formatadores e testes para cada pull request contendo mudanças geradas pela IAdocs.github.com. Ferramentas de segurança como CodeQL podem detectar padrões vulneráveis comuns que um desenvolvedor ou a IA possam ter introduzidodocs.github.com. Idealmente, nenhuma sugestão de IA vai direto para produção sem passar pelo mesmo rigor de validação que código escrito manualmente. Se possível, utilize também ferramentas de IA para revisar a IA: por exemplo, usar um agente para inspecionar o diff de um PR e comentar potenciais problemas (há pesquisas e ferramentas emergindo para essa “auto-review” de pull requestsdocs.github.com). Embora não substitua o juízo humano, isso pode pinçar pontos de atenção antes mesmo dos revisores humanos olharem.

- Melhoria Contínua e Feedback ao Processo: Trate cada uso da IA como uma oportunidade de aprendizado. Quando um bug passa pelos filtros ou uma sugestão se prova problemática, retroalimente esse conhecimento. Atualize a documentação de contribuições do projeto para incluir guidelines de uso de IA – ex.: exigir que a origem de um algoritmo sugerido seja citada, ou que TODOs introduzidos pela IA sejam resolvidos antes do mergedocs.github.com. Desenvolva internamente uma cultura de “uso responsável de IA”, compartilhando dicas entre a equipe: quais prompts funcionam melhor, quais armadilhas evitar, exemplos de falhas ocorridas e como mitigá-las. Com o tempo, essa base de melhores práticas aumenta a confiança de que o código gerado está sendo bem controlado.

Seguindo essas etapas – testar, validar contexto, checar qualidade, auditar dependências, caçar pegadinhas, revisar e automatizar verificações – é possível incorporar contribuições de IA ao código com segurança e qualidadedocs.github.comdocs.github.com. Em suma, a IA pode gerar um “draft” de código, mas a responsabilidade final pela corretude é sempre do time de desenvolvimento.

Matriz de Adequação de Abordagens

Cada abordagem de uso de IA no desenvolvimento apresenta pontos fortes e contextos em que é mais eficaz. Abaixo, um resumo de quando usar cada abordagem (do fluxo mais simples ao mais sofisticado), considerando tipo de projeto, complexidade, tamanho de equipe e restrições:

- Chat Externo + Copiar/Colar: Ideal para prototipação rápida, problemas isolados ou projetos pequenos. Se você está explorando uma ideia nova ou trabalhando em um script independente, usar uma IA no navegador (como ChatGPT) pode acelerar obtendo trechos de código prontos. Também é útil para pesquisa de soluções – por exemplo, “como faço X em Python?” – onde o resultado é um snippet a ser adaptado manualmente. Equipes pequenas ou desenvolvedores solo em projetos open-source costumam adotar essa abordagem informal. A simplicidade do copiar-colar funciona bem quando o escopo de mudança é limitado e a falta de integração não atrapalha. Em contrapartida, não é ideal quando se precisa modificar muitas partes do sistema ao mesmo tempo (a produtividade cai com o vai-e-vem) ou quando há preocupações de privacidade severas (pois requer colar possivelmente partes do código proprietário num serviço de terceiros). Use esse fluxo quando a rapidez de obter um código exemplificativo é mais importante do que a comodidade de integração – por exemplo, ao experimentar uma nova API ou algoritmo fora do projeto principal.

- IA Integrada como Extensão em IDE Tradicional: Recomendada para o desenvolvimento cotidiano em projetos de porte médio a grande, onde o dev precisa de assistência constante mas quer permanecer no próprio ambiente. Ferramentas como Copilot no VS Code/Visual Studio se encaixam bem em equipes de software estabelecidas, pois suportam múltiplas linguagens e frameworks e se adaptam a projetos em crescimento. Essa abordagem brilha em cenários de implementação incremental: construção de novas funcionalidades seguindo o design existente, escrita de testes unitários, refatorações moderadas. Ela melhora a produtividade individual sem alterar drasticamente o fluxo de trabalho do time – cada dev continua rodando seu editor, apenas recebendo sugestões inline e podendo consultar o AI chat para dúvidas. É especialmente eficaz quando o projeto possui base de código consolidada (a IA consegue fornecer sugestões contextuais relevantes, p.ex. usar funções utilitárias internas corretamente) e para tarefas rotineiras (escrever código boilerplate, converter uma função de síncrona para assíncrona, etc.). Equipes maiores apreciam que soluções como Copilot Enterprise trazem configurações de filtro (p.ex. para não sugerir código de licenças conflitantes) e log corporativo de uso para complianceitecsonline.com. Em resumo, se você tem um projeto profissional em andamento e quer aumentar a velocidade mantendo controle humano linha a linha, a IA integrada à IDE é o caminho mais natural.

- Editor Especializado com IA (e.g. Cursor): A escolha ideal quando a equipe ou desenvolvedor deseja maximizar a automação nas tarefas de codificação e está disposto a adotar uma ferramenta nova focada em AI. Essa abordagem beneficia projetos onde há muitas refatorações extensas ou código repetitivo a ser criado – por exemplo, migrar uma base de código para um novo padrão, ou gerar esqueleto de dezenas de componentes similares. Startups e times de tecnologia de ponta têm usado editores como o Cursor para ganhar velocidade em protótipos e ferramentas internas, onde pequenas imperfeições são toleráveis em troca de agilidade. No Cursor, o desenvolvedor consegue realizar mudanças abrangentes com comandos simples (é como ter um pair programmer virtual altamente eficaz ao lado). Portanto, é indicado em contextos onde a prioridade é velocidade sobre formalidades – hackathons, MVPs, ou projetos menos críticos – e onde os membros do time têm habilidade para revisar rapidamente diffs gerados. Por outro lado, se o ambiente da organização exige certas garantias (auditorias detalhadas, aprovação em cada mudança), o Cursor pode ser menos adequado, pois ainda não fornece logs de raciocínio ou justificativas robustas para cada modificaçãoitecsonline.com. Em suma, use um editor AI-first quando quer levar o “co-piloto” ao máximo, acelerando desenvolvimentos com o risco controlado por uma boa suite de testes e desenvolvedores experientes para supervisionar. É a ferramenta certa para trabalhos repetitivos, extensos e bem estruturados, onde a IA pode fazer em minutos o que humanos levariam horas, liberando tempo para tarefas mais criativas.

- Plataforma de Agente Autônomo (e.g. Google Antigravity): Mais adequada em cenários futuristas ou experimentais, onde se busca automatizar fluxos de desenvolvimento completos. Pense em uma situação de alta complexidade: por exemplo, atualizar toda a interface de um aplicativo, ajustar o backend e garantir que tudo funcione – tradicionalmente exigindo muita coordenação manual. Nesses casos, a abordagem de agentes autônomos pode trazer enormes ganhos de produtividade, delegando ao AI tasks como “implementar a Feature X do front ao back e testar”. Organizações com projetos muito complexos e bem testados podem colher benefícios testando o Antigravity: se há confiança na suite de testes automatizados, um agente pode propor uma grande mudança e validá-la executando esses testes e mostrando resultados. Também pode ser útil em empresas que mantenham ferramentas internas complicadas (script de deploy, migrações de banco, etc.) – um agente pode realizar essas operações continuamente em background (ex: atualizar dependências e verificar se nada quebrou). Contudo, devido à novidade, recomendamos esta abordagem em projetos não críticos inicialmente. Grandes empresas de tecnologia podem rodar pilotos do Antigravity em módulos isolados ou ferramentas auxiliares, com desenvolvedores sêniores monitorando, para avaliar os prós e contrasitecsonline.com. Contextos em que cada ganho de eficiência vale ouro – como times reduzidos enfrentando um legado enorme – também justificam investir na curva de aprendizado dessa plataforma. Importante: se sua organização tem restrições rígidas (compliance, dados sensíveis), é preciso cautela extra, pois a autonomia do agente envolve acesso amplo ao código e possivelmente dados de teste. A Google ainda está evoluindo políticas e certificações para o Antigravity, então no curto prazo setores regulados tenderão a esperar antes de adoção plenaitecsonline.com. Em suma, a abordagem de agentes autônomos é mais eficaz quando buscamos eficácia em alto nível (menos intervenção humana em cada etapa), em contextos com boa base de testes e supervisão, e para tarefas definidas de forma clara (onde o agente consegue planejar concretamente). É uma aposta para aumentar a escala do desenvolvimento no futuro, já demonstrando casos de sucesso em acelerar manutenção e iteração de UI com feedback visual rápidodevelopers.googleblog.com.

Categorias de Problemas: Onde a IA Excele vs. Onde Falha

Ao aplicar IA no desenvolvimento, percebemos que ela se sai muito bem em alguns tipos de problemas, mas tem dificuldades marcantes em outros. A seguir, duas listas – a primeira destaca situações em que a IA resolve problemas com excelência, e a segunda aponta casos onde a IA falha ou apresenta limitações críticas:

Problemas onde a IA excele 📈

- Prototipação Rápida e “Spike” de Tecnologias Desconhecidas: A IA é excepcional para tirar ideias do papel rapidamente. Dada uma descrição de alto nível, ela consegue produzir um protótipo funcional em tempo recorde. Isso é valioso ao experimentar com tecnologias ou linguagens pouco familiares – por exemplo, gerar código Delphi para portar para Go sem conhecer bem Pascal, ou esboçar um front-end mesmo sendo um desenvolvedor mais de back-endlinkedin.com. Em minutos, obtém-se um draft que permite avaliar se a abordagem vale a pena, encurtando a fase de experimentação. O código pode não estar pronto para produção, mas como prova de conceito ou aprendizado inicial, o ganho de velocidade é enorme.

- Implementação de Funcionalidades de Forma Consistente em Múltiplos Locais: A IA brilha quando precisa replicar um padrão de mudança em diversos pontos do código. Por exemplo, “tornar uma coluna de banco não nula” pode envolver alteração em modelo, lógica de negócio e testes. Uma boa ferramenta de IA pode aplicar todas essas mudanças coordenadamente em segundoslinkedin.com, garantindo que nenhum lugar seja esquecido. Tarefas de manutenção como remover um feature flag, que pedem encontrar e eliminar trechos relacionados espalhados no projeto, também entram aqui. Nesses casos de solução bem definida e repetitiva, a IA atua como um desenvolvedor sênior extremamente rápido e atento, seguindo instruções ao pé da letra em cada canto relevante do sistema.

- Geração de Código Boilerplate e Rotinas Padronizadas: Sempre que a tarefa envolve muito código cerimonial ou repetitivo, a IA mostra desempenho excelente. Isso inclui criar funções getters/setters, scaffolding de componentes, mapeamento de DTOs, configurações padrão e afins. Coisas como “crie classes de entidade e repositório para essas 10 tabelas” ou “implemente métodos CRUD básicos para este modelo” podem ser quase inteiramente delegadas. A IA produz esses blocos triviais de forma consistente e sem reclamar – economizando tempo do desenvolvedor para focar na lógica específica do negócio. Em resumo, em problemas onde já se sabe exatamente o formato do código de saída (só é maçante escrevê-lo manualmente), a automação via IA atinge qualidade de especialista, sem erros de digitação e seguindo o padrão exemplar.

- Ser um “Parceiro de Design” e Refatoração: Surpreendentemente, LLMs podem atuar como um assistente de arquitetura em nível conceitual. Você pode apontar um trecho de código ou descrever um módulo e perguntar: “Quais outras maneiras de projetar isto?”. A IA consegue propor alternativas de design e discutir prós e contraslinkedin.com, servindo como um sounding board para arquitetos e desenvolvedores. Isso não significa que ela cria a arquitetura ideal sozinha (ver limitações abaixo), mas para brainstorming e análise de trade-offs ela é útil. Também, ao passar código existente, a IA frequentemente sugere melhorias de clareza, extração de funções ou eliminação de duplicações – funcionando como um par que sempre tem alguma recomendação de refatoração. Esse papel de “design partner” se estende a explicação de código legado: a IA resume o que um trecho complexo faz, facilitando entendê-lo para depois refatorar.

- Seguir Exemplos e Produzir Código em Massa (até certo limite): Se fornecemos exemplos claros, a IA consegue estender um padrão para novos casos muito rapidamente. Um desenvolvedor relata pedir para gerar código seguindo o estilo de alguns exemplos fornecidos, e contanto que o volume não seja excessivo (digamos, até umas 300 linhas de código), a IA “despeja” a solução malhando o exemplo incansavelmentelinkedin.com. Imagine querer adicionar 5 novos endpoints similares a outros já existentes – a IA pode duplicar e ajustar cada um em segundos, mantendo consistência. Esta capacidade de escalabilidade de esforço (fazer em segundos o que levaria horas repetindo uma mesma lógica) é um ganho notável de produtividade e, quando bem orientada, vem com qualidade boa ou até superior (pois a IA não entedia de repetir tarefas). Em resumo, problemas onde existe um modelo claro a seguir e pouca ambiguidade tendem a ser resolvidos com maestria pela IA.

- Geração de Testes Unitários e Casos de Teste: Outra área onde IA costuma ir bem é na criação de testes para código já escrito. Dado um método ou funcionalidade, a IA pode sugerir um conjunto de casos de teste abrangentes rapidamente, incluindo testes para cenários felizes e alguns casos de erro. Embora o desenvolvedor deva revisar se cobrem corretamente as especificidades, isso adianta muito o trabalho. Ferramentas como Copilot chegam a gerar testes JUnit, por exemplo, antes mesmo do dev pensar neles. Esse é um tipo de problema de “saída fechada” – há formas típicas de testar coisas – e a IA conhece muitos padrões de teste de seu treinamento, aplicando-os com rapidez.

Problemas onde a IA falha ou tem limitações ⚠️

- Projetar Arquiteturas ou Soluções de Alto Nível Ambíguas: Quando o problema não tem um caminho único de resolução – isto é, um espaço de solução aberto com múltiplas abordagens possíveis –, a IA geralmente tropeça. Ela não possui julgamento arquitetural nem visão holística de longo prazo. Pode até escrever funções ou classes isoladas bem (nivel “engenheiro sênior” em implementação), mas toma decisões de design como um engenheiro júnior, sem questionar requisitos ou avaliar implicações globaisblog.thepete.netblog.thepete.net. Em tarefas como “conceber um módulo de upload de arquivos com suporte a múltiplas fotos”, onde há dezenas de escolhas (fluxo de UX, API, tratamento de erro, limites, bibliotecas a usar), a IA tende a escolher algo arbitrário ou padrão, muitas vezes duplicando lógica, violando princípios DRY e inconsistência de estilo pelo códigolinkedin.com. Ela não entende verdadeiramente as metas de longo prazo do sistema, então suas decisões de arquitetura podem levar a soluções decepcionantes ou não ideaisblog.thepete.netblog.thepete.net. Em suma, problemas mal definidos, que demandam criatividade arquitetural, síntese de requisitos e avaliação de trade-offs, não são o forte da IA – a probabilidade dela escolher o caminho errado é alta a menos que você especifique minuciosamente o que fazer.

- Necessidade de Contexto Implícito Extenso: Se resolver um problema depende de conhecimento específico do domínio, convenções do time ou detalhes espalhados no códigobase que não foram fornecidos no prompt, a IA fica prejudicada. Cada nova sessão de LLM é como um “funcionário novo” que não sabe nada do projeto além do que você mostrarblog.thepete.netblog.thepete.net. Por exemplo, pedir para implementar uma funcionalidade complexa sem fornecer as classes de suporte, configurações e regras de negócio relacionadas provavelmente resultará em código incompatível com o restante do sistema. A IA não vai aderir espontaneamente a todas as práticas do time (nomenclaturas, frameworks preferidos, utilitários existentes) se isso não estiver explícitoblog.thepete.net. Essa falta de contexto implícito leva a soluções erradas simplesmente porque o agente “não sabia” de algo crucial – como uma função util já implementada ou um requisito não mencionado. Portanto, problemas que envolvem muito conhecimento tácito ou transversal (ex: integrar várias partes de um sistema grande respeitando padrões existentes) costumam expor as limitações de contexto da IA. A menos que se alimente ao modelo todo o material relevante (documentação interna, código envolvido) e mesmo assim supervisionar de perto, a chance de erro ou de escolhas inadequadas por desconhecimento é grande.

- Seguir Especificações Estritas ou Múltiplas Restrições Simultaneamente: IAs muitas vezes têm dificuldade em obedecer rigorosamente a todos os detalhes de instruções complexas. Você pode fornecer guias de estilo, padrões de formatação, regras de arquitetura, etc., porém na prática o modelo consegue manter talvez metade disso na saídalinkedin.com. Por exemplo, se você disser para não usar comentários desnecessários, seguir 10 regras de estilo e ainda aplicar um design pattern específico, é bem provável que parte dessas instruções seja esquecida ou aplicada incorretamente conforme a resposta se alonga. Em sessões de chat mais extensas, esse problema piora – o modelo começa a divergir das orientações iniciais, “esquecendo” um detalhe ou outro. Desenvolvedores relatam frustração em fazê-lo parar de gerar trechos indesejados (como comentários redundantes) – parece impossível impedir completamente certos vícioslinkedin.com. Assim, problemas que exigem alta aderência a padrões formais ou requisitos detalhados (por exemplo, conformidade estrita a MISRA C, ou um algoritmo que deve ser 100% estável e deterministicamente igual a uma especificação matemática) podem revelar as falhas de consistência da IA. Ela não tem um mecanismo garantido de seguir regras à risca quando a situação é complexa; acaba escapando algum detalhe, exigindo revisão e correção manual depois.

- Correção de Bugs Complexos e Depuração Profunda: Embora as IAs ajudem a encontrar e corrigir bugs típicos ou erros simples, elas não são tão eficazes diante de bugs sutis e novelos em sistemas grandes. Um bug que requer entender estado global, múltiplos fios de execução, ou reproduzir cenários específicos do ambiente real pode estar além da capacidade do modelo (que não executa código, apenas prevê respostas). Muitas vezes, a IA acerta os bugs óbvios (null pointer, erro de sintaxe, condição malformada) mas falha em consertar problemas lógicos intricados. Pior: às vezes ela sugere uma “solução” que mascara o sintoma sem resolver a causa raiz. Por exemplo, pode pegar um teste que falha e simplesmente removê-lo ou marcar como ignorado, para que tudo fique “verde”docs.github.com – claramente uma má prática. Em debugging, a IA não tem ferramentas de introspecção reais; se o bug exigir examinar um heap dump ou comportamento de runtime complexo, o desenvolvedor humano precisa intervir. Logo, problemas não determinísticos ou de integração complexa (condições de corrida, memory leak, incompatibilidade entre serviços) permanecem difíceis para IA. Ela pode ajudar com hipóteses ou explicar o stack trace, mas é o humano que precisa validar e realmente resolver.

- Otimização e Código de Alta Performance: Se o desafio é produzir código extremamente otimizado (em termos de desempenho ou uso de recursos), a IA tende a falhar em atingir a solução ideal. Ela geralmente gera a implementação mais direta, sem aplicar truques de otimização ou estruturas algorítmicas avançadas além do que estava em seus exemplos de treino. Por exemplo, pedir para escrever um algoritmo de caminho mínimo altamente otimizado pode resultar em uma solução correta, porém não necessariamente a mais performática. Ajustes finos como otimização de memória, uso de SIMD, intrínsecos específicos de CPU, ou micro-otimizações de loop dificilmente aparecerão a menos que expressemos explicitamente. Em alguns casos, a IA até desotimiza o código – p.ex., substituindo uma solução linear por outra mais genérica porém menos eficiente, por não entender as nuances do caso de uso. Portanto, problemas que requerem engenharia de performance, tuning fino ou soluções algorítmicas fora do comum não são bem atendidos pela IA. Nessas situações, o julgamento e experiência humana (ou algoritmos clássicos do domínio) ainda superam a “criatividade” preditiva do modelo.

- Criatividade Verdadeira e Inovação: Embora consigam ser “criativos” dentro do espaço de combinações do que já viram, LLMs não inventam algoritmos ou paradigmas totalmente novos. Se você tem um problema realmente original, sem muita referência conhecida (por exemplo, criar um algoritmo inédito, ou um design de arquitetura revolucionário), a IA patina – ela tende a propor o mais parecido possível com algo já existente nos dados dela. Para inovação de verdade, dependemos de engenheiros humanos pensando fora da caixa. Um sinal disso é que a IA raramente diz “não faça X, faça Y radicalmente diferente”, pois não tem senso crítico forte para tal. Portanto, problemas que exigem insight original, pesquisa de solução inédita ou muita criatividade de design ficam fora do alcance efetivo das IAs atuais.

- Persistência e Consistência em Grandes Mudanças: Se uma tarefa envolve refatorar massivamente um grande codebase mantendo total consistência, a IA pode se atrapalhar. Por exemplo, migrar todo um sistema para um novo framework ou renomear sistematicamente domínios de negócio em centenas de lugares – a IA pode até ajudar gerando scripts ou fazendo alguns arquivos, mas manter a coesão em todas as peças é desafiante. Frequentemente o modelo não consegue “lembrar” de decisões tomadas nos primeiros arquivos quando já está no quinquagésimo. Ferramentas AI-first como Cursor tentam mitigar isso carregando mais contexto, mas ainda assim, refatorações extensas costumam exigir monitoramento humano constante. Em contrapartida, uma IDE com recursos de refatoração tradicional (renomear simbolicamente, análises estáticas) possivelmente será mais segura para alterações globais. Então, em problemas do tipo “transformação em larga escala” no código, a IA ajuda a planejar e até executar parcialmente, mas não se deve confiar cegamente sem rodar uma bateria completa de testes e revisões. Pequenas incoerências introduzidas pela IA em diferentes partes podem gerar um efeito dominó de bugs difíceis de detectar.

- Autoavaliação e Pensamento Crítico: A IA não sabe dizer quando seu código está realmente correto ou não – ela não tem consciência do funcionamento real. Por isso, falha em problemas que exigem questionar os próprios resultados. Ela tende a ser muito confiante mesmo quando está errada. Por exemplo, em design de sistemas, um humano pode rejeitar uma solução por prever problemas futuros, mas a IA raramente vai contra sua própria proposta ou alertar “isso pode não ser uma boa ideia”. Como mencionado, modelos como Claude às vezes elogiam qualquer sugestão do usuário como ótimalinkedin.com, em vez de desempenhar o papel de advogado do diabo. Assim, se o problema requer uma análise crítica – do tipo “esta solução é a melhor ou devemos considerar outra abordagem?” – a IA sozinha não faz esse julgamento honesto. Precisa do humano para avaliar meta-critérios (manutenibilidade, custo-benefício, aderência ao que não foi dito explicitamente, etc.). Em suma, a IA falha onde é preciso tomar decisões conscientes e ponderadas sobre o próprio código gerado.

(Em síntese, a IA excele em tarefas fechadas, repetitivas e bem mapeadas – é como um motor que amplifica trabalho braçal de codificação – mas falha quando o problema demanda compreensão profunda, criatividade e julgamento refinado, características tipicamente humanas.)

Diferenças Práticas entre Abordagens (Produtividade, Segurança, Qualidade, Velocidade)

As diferentes formas de incorporar IA no fluxo de desenvolvimento implicam também distintos impactos em produtividade, segurança do código, qualidade e mantenibilidade. Abaixo estão as principais diferenças práticas observadas:

- Produtividade e Velocidade de Desenvolvimento: De modo geral, todas as abordagens de IA buscam aumentar a produtividade, mas o grau de aceleração varia. Abordagens integradas (Copilot em IDE, Cursor) tendem a oferecer ganhos incrementais constantes – sugestões line-by-line e assistências que economizam segundos a todo momento, somando minutos ou horas ganhos por dia. Já abordagens mais avançadas (como agentes autônomos) podem trazer saltos de produtividade em tarefas específicas, concluindo em minutos o que seria um trabalho de dias. Entretanto, esse ganho bruto de velocidade vem acompanhado de tempo de validação e ajustes. Em outras palavras, com IA você codifica muito mais rápido, mas deve reservar tempo para testes e revisões que antes eram gastos pensando e digitando. Estudos apontam melhorias substanciais no tempo de completar tarefas com ferramentas como Copilot (desenvolvedores realizando tarefas ~55% mais rápido em média) – porém, isso reflete em nível de micro-tarefasblink.ucsd.edu. No contexto macro (entrega de um projeto completo), os ganhos podem diluir se houver retrabalho ou se a equipe não gerenciar bem a integração das partes geradas. Uma diferença notável de fluxo é que no copiar-colar tradicional, a velocidade está limitada pelo colaborador humano (o dev precisa orquestrar cada interação, tornando-o consciente do processo), enquanto nas abordagens integradas a IA pode operar em segundo plano (e até de forma paralela, no caso de agentes). Isso significa que ferramentas como Antigravity podem aumentar throughput dramáticamente – um único desenvolvedor pode conduzir vários agentes fazendo coisas diferentes simultaneamente. Entretanto, a coordenação e verificação desses agentes vira parte do trabalho. Em resumo, IA integrada -> produtividade incremental, boa para fast feedback loops; IA autônoma -> produtividade em lote, excelente para big tasks mas com sobrecarga de supervisão. Importante salientar que velocidade sem direção pode ser desperdício: há casos de desenvolvedores gerando muito código rapidamente, mas depois gastando muito tempo corrigindo rumo (“vibe coding” levando a um caos não mantenívellinkedin.com). Portanto, velocidade é um benefício real, mas requer uma cultura de qualidade para se traduzir em produto final mais rápido.

- Qualidade de Código e Controle de Qualidade: As abordagens variam em quão fácil é manter a qualidade do código gerado. No fluxo copiar-colar, paradoxalmente, o desenvolvedor acaba exercendo mais controle de qualidade manual, pois inspeciona cada saída enquanto a integra ao projeto. Isso pode resultar em menos erros óbvios passando despercebidos (o dev é forçado a ler, adaptar e testar cada trecho colado). Já nas integrações diretas, é tentador aceitar sugestões com um simples tab ou clique – o que pode introduzir pequenos bugs ou inconsistências se a revisão for superficial. Ferramentas como Copilot oferecem algumas ajudas, por exemplo alertas se a sugestão corresponde muito a um trecho de código público (potencial licenciamento), mas não “garantem” correção. Modelos de IDE especializada (Cursor) focam em manter contexto para gerar mudanças consistentes, o que pode elevar a qualidade percebida (ex.: refatorações propostas já vem alinhadas com o código circundante, reduzindo retrabalho). No entanto, também se observou que o Cursor às vezes faz modificações simultâneas em múltiplos arquivos com documentação mínima do porquê, dificultando revisar decisão por decisãoitecsonline.com. Isso é diferente de um desenvolvedor humano, que ao fazer um grande refactor normalmente justificaria em comentários de PR. Assim, a equipe precisa compensar essa falta de insight, testando e lendo todas as mudanças com atenção. Já o Antigravity tenta melhorar qualidade embutindo verificações automáticas (os agentes executam testes, geram artifacts de prova), servindo como uma espécie de QA interno durante a geraçãodevelopers.googleblog.comdevelopers.googleblog.com. Essa verificação autônoma pode pegar erros que um Copilot não pegaria (porque Copilot apenas sugere, não executa nada). Então, em teoria, a abordagem agentiva pode levar a menos bugs óbvios no resultado final, dado que o agente se validou. Contudo, confiar nisso sem dupla checagem humana seria arriscado. Em termos de controle de qualidade, as empresas podem integrar IA também nessa fase: por exemplo, usar análises estáticas e até modelos para revisar PRs. Vale notar que a mesma IA que escreve o código pode ser usada para melhorar a qualidade – pedindo para ela gerar testes ou identificar problemas no seu próprio outputdocs.github.com. Ainda assim, uma preocupação real é alucinações ou erros sutis passarem desapercebidos se os desenvolvedores se acomodarem. A tendência “aceita-e-avança” pode minar a qualidade a longo prazo. Portanto, equipes disciplinadas impõem regras como: IA não elimina code review, sempre rodar todos testes após gerações maiores, etc. Em suma, manter a qualidade exige um esforço consciente independentemente da ferramenta, mas ferramentas com transparência limitada (ex: alterações multi-arquivo sem explicação) demandam esforço extra de revisão. Uma boa prática emergente é instituir verificações automáticas e manuais proporcionais à magnitude/criticidade da contribuição da IA.

- Segurança do Código (Vulnerabilidades e Exposição de Dados): A segurança é um ponto de atenção grande ao adotar IA. Pesquisas revelaram que modelos de programação podem sugerir soluções inseguras se não forem orientados adequadamente – por exemplo, usar métodos criptográficos desatualizados ou vulneráveis presentes nos dados de treino. Um estudo sobre código gerado pelo Copilot identificou vulnerabilidades em cerca de 30% dos trechos Python e 24% em JavaScript analisadosdl.acm.org. Ou seja, sem filtragem e revisão, há um risco concreto de introduzir security bugs. Abordagens integradas (Copilot, Cursor) já implementam algumas mitigações: filtrar saídas conhecidamente inseguras ou consignas de exploits, mas não pegam tudo. Portanto, o time de desenvolvimento deve estar vigilante – usando as metodologias de avaliação descritas antes (análise estática de segurança, revisão focada em OWASP Top 10, etc.). Quanto à exposição de dados sensíveis, o fluxo copiar-colar coloca o ônus no usuário: ele decide o que enviar à IA, podendo omitir trechos confidenciais. Já integrações automáticas enviam contexto do código para a nuvem do provedor de IA continuamente, o que levanta questões de compliance. Soluções enterprise do Copilot prometem zero retenção de dados e filtros de segredo (para não sugerir segredos conhecidos)itecsonline.com, mas um erro de configuração ou uma vulnerabilidade pode vazar informação. Inclusive, houve relatos em 2025 de uma falha no Copilot Chat que permitiria exfiltrar silenciosamente trechos de código privado através de respostas formatadas de um certo modolegitsecurity.com. Assim, em termos de segurança organizacional, ferramentas maduras (Copilot Enterprise) têm vantagem de já possuírem avaliações de conformidade e opções de self-hosting via Azure OpenAI (no caso da Microsoft), enquanto ferramentas novas (Cursor, Antigravity) podem não ter passado por auditorias extensivas aindaitecsonline.comitecsonline.com. Empresas muito reguladas preferem aquilo que já foi testado e certificado. Um diferencial do Antigravity no aspecto segurança é a geração de artefatos verificáveis: por exemplo, ele pode mostrar uma gravação de tela provando que usou dados de teste e não dados reais em uma operação, criando evidências para auditoriaitecsonline.com. Essa transparência é promissora para atender requisitos de compliance (mostrar exatamente o que a IA fez e com que dados), mas até que a plataforma seja validada, a maioria ficará reticente em usá-la em ambientes com dados sensíveis. Em resumo, as abordagens diferem em maturidade de segurança: hoje, Copilot em empresas grandes coloca foco em limitar riscos (filtrar, logar, não reter), enquanto editores independentes dão agilidade mas exigem confiança no provedor de LLM escolhido. Independentemente da ferramenta, o time deve pensar em segurança: não pedir código pronto de IA sem sanidade de segurança, evitar compartilhar segredos no prompt, e talvez restringir a IA a ambientes/dados fake quando testando coisas como migração de banco etc. Lembrando sempre que a responsabilidade última por proteger a base de código e os dados é humana – a IA é uma ferramenta que deve ser usada sob políticas e monitoramento adequados.

- Rastreabilidade e Auditoria das Mudanças: Conforme equipes começam a delegar mais trabalho à IA, surge a questão: Quem escreveu esse código e por quê?. No fluxo manual tradicional, cada commit tem um autor e geralmente uma mensagem explicando a mudança. Com IA integrada fazendo pequenas sugestões, isso se dilui – a autoria acaba mista, e se o desenvolvedor não documentar, pode ser difícil saber se um trecho veio da IA ou não. Abordagens modernas estão tentando suprir essa necessidade de traceabilidade. O GitHub Copilot Enterprise, por exemplo, mantém logs de uso que registram chamadas à API (quem pediu o quê e quando)itecsonline.com. Contudo, esses logs mostram a interação, não necessariamente o raciocínio ou justificativa da mudança. No Cursor, há ainda menos visibilidade por padrão: quando ele modifica vários arquivos com o recurso Composer, o dev apenas vê o diff final aplicado, sem uma explicação detalhada do racionalitecsonline.com. Para organizações que precisam de auditoria (p.ex. ver por que certo código foi alterado meses depois), isso é um desafio – exigindo práticas adicionais, como gerar tickets ou comentários manuais explicando as alterações feitas por IA. O Google Antigravity vai mais longe ao incorporar auditabilidade no design: cada ação do agente produz artifacts (lista de passos, planos, evidências visuais) que podem ser armazenados para revisão posteriordevelopers.googleblog.com. Além disso, o Antigravity mantém um “knowledge base” do que o agente aprendeu e fez, trazendo um histórico mais rico. Essa abordagem visa justamente empresas que pedem trilhas de auditoria completas (financeiras, saúde, etc.), permitindo reconstruir como e por que uma implementação foi realizada pela IAitecsonline.comitecsonline.com. Em termos práticos: hoje, se a rastreabilidade for crítica, a opção mais confiável é usar a IA de forma restrita e documentar manualmente (ex: incluir no pull request – “este código foi gerado via ChatGPT com prompt X”). Ferramentas consolidadas como Copilot não gravam a conversa nem a justificativa, apenas o uso. Com Antigravity no futuro, talvez cada commit venha acompanhado de um pacote de artifacts mostrando o processo. Então vemos divergência: fluxo copy-paste – o dev tem o chat log separado (pouca integração, mas se salvar pode referenciar depois); fluxo integrado comum – mínimo extra além do código final, exigindo disciplina para comentar; fluxo agentivo Antigravity – builtin evidências e potencial para audit trail robusto (desde que se arquive os artifacts). Novamente, a maturidade organizacional conta: equipes em setores regulados hoje tenderão a preferir Copilot Enterprise por ter pelo menos logs e já se integrar aos processos existentes de compliance, enquanto exploram o Antigravity em paralelo para avaliar se suas capacidades de verificação podem satisfazer auditores futuramenteitecsonline.comitecsonline.com.

- Manutenibilidade e Dívida Técnica: Uma preocupação de longo prazo é como o uso de IA afeta a saúde do código no decorrer do tempo. Nas abordagens mais leves (sugestões lineares), o risco de dívida técnica decorre mais do excesso de confiança do desenvolvedor – aceitar código gerado sem entender totalmente pode introduzir soluções subótimas ou discrepantes do resto da base. Por exemplo, a IA pode resolver um problema local mas duplicar lógica que já existia em outro módulo, criando redundância que aumenta custo de manutenção. Se a equipe não faz revisão cuidadosa, essas duplicidades e estilos misturados podem acumular. Contudo, se bem utilizado, um Copilot pode também reduzir dívida técnica ao auxiliar em refatorações consistentes (um dev disciplinado pode usar a IA para remover código legado de forma mais rápida e uniforme). A chave é o humano direcionar o uso para pagar dívidas, não criar novas. Em abordagens mais agressivas, como “vibe coding” (onde desenvolvedores geram grandes trechos por feeling), viu-se casos de projetos virarem uma colcha de retalhos difícil de manterlinkedin.com. Código gerado em excesso, sem uma arquitetura clara, leva a um produto funcionando no curto prazo mas frágil e confuso no longo prazo. Portanto, a maintainability está ligada à supervisão: o Antigravity, por exemplo, pode reescrever partes enormes – se isso for feito atendendo a um bom plano arquitetural, ótimo (a IA pode até melhorar a coesão ao fazer refactors amplos). Mas se a tarefa não for bem especificada, o agente pode introduzir mudanças difusas, como renomear coisas sem real necessidade ou reorganizar o projeto de forma arbitrária, e a equipe terá trabalho para entender o novo formato. Ferramentas agentivas precisam ser configuradas com políticas de revisão (e o Antigravity de fato permite definir políticas de aprovação manual para certos passos) para que a manutenibilidade não sofra. Outro aspecto é consistência de estilo e padrões: com vários devs humanos, as diferenças de estilo são contornadas com linters e code reviews; com IA, teoricamente o estilo deveria ser mais uniforme (já que um só modelo gera muita coisa), mas na prática, se diferentes modelos forem usados (ex: um dev usa GPT-4, outro Claude), podem entrar estilos divergentes. Padronizar a IA (mesmo modelo/config para todos) ou ter um guia de estilo que a equipe toda reforça nos prompts pode mitigar isso. Além disso, hoje o Copilot já evita sugerir código idêntico a trechos públicos com licença restrita, o que previne um tipo de débito técnico/legal – dependência acidental de código externo. Em maintainability, também pesa o fator buscabilidade e documentação: código escrito por IA pode carecer de comentários ou referências que um humano normalmente colocaria pensando em futuros leitores. Por isso, devs devem pedir explicitamente: “documente esta função” ou adicionar comentários depois. Agentes autônomos gerando artifacts ajudam nisso (deixam rastro do porquê), mas se esses artifacts não forem vinculados ao código (ex: commit message ou doc interna), perdem-se. Concluindo, as abordagens diferem em quanto esforço humano precisa ser investido para manter o código sustentável. As integradas comuns requerem esforço moderado (o dev já acompanha linha a linha e pode ajustar na hora), as de copiar-colar podem até forçar mais esclarecimento (pois o dev integra manualmente e talvez escreva comentários enquanto entende), e as de automação pesada pedem um esforço concentrado de revisão e documentação pós-geraçāo para evitar tech debt. Não é surpresa que consultorias recomendam cautela: por exemplo, manter o Cursor para prototipação e introduzir o Antigravity de forma incremental – assim a base de produção continua principalmente sob controle tradicional, até que se confie que os agentes não gerarão débito ocultoitecsonline.com.

Em termos de segurança de código, rastreabilidade, qualidade e velocidade, podemos resumir: ferramentas convencionais como VS Code + Copilot oferecem ganho equilibrado em produtividade com riscos relativamente administráveis (desde que usados com processo); ferramentas AI-first como Cursor empurram a produtividade no limite, porém exigem compensações em governança e verificação manual; já a abordagem de agentes promete saltos de eficiência em tarefas complexas e melhor documentação intrínseca (artifacts), mas por enquanto carece de comprovação para usos críticos e implica em muito teste e iteração para garantir segurança/qualidade. Em qualquer caso, o uso eficaz de IA no desenvolvimento não elimina as boas práticas – ele as torna ainda mais importantes. Times que internalizam isso conseguem extrair o melhor dessas ferramentas, colhendo ganhos de velocidade e inteligência, ao mesmo tempo mantendo a qualidade de software, a segurança e a manutenibilidade sob controle. Como tendência, espera-se que os fluxos de trabalho evoluam para combinar o melhor dos dois mundos: IA acelerando o trivial e dando contexto, humanos supervisionando, refinando e tomando decisões de alto nível, resultando em software produzido de forma mais rápida porém com confiança e clareza de sempre.