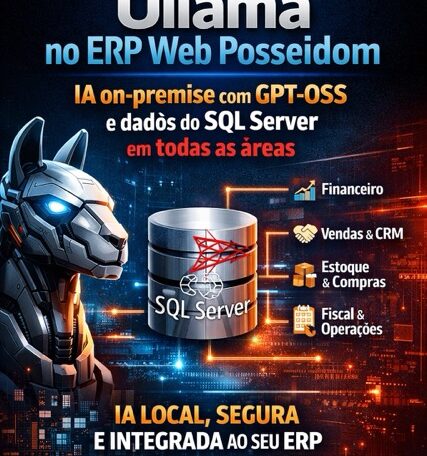

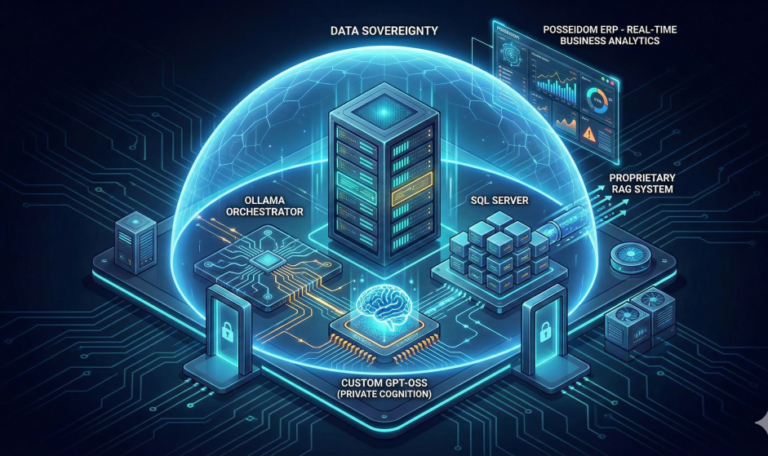

🧠 Introdução — Informação não é mais o problema. Interpretação é. Durante muito tempo, empresas investiram em sistemas de gestão para registrar dados: 📄 notas fiscais, 💰 contas a pagar, 📦 estoque, 📈 vendas. Hoje, isso já não é diferencial. O verdadeiro gargalo está em outro ponto: ❌ Dados existem ❌ Relatórios existem ❌ Mas decisões continuam atrasadas ou baseadas em intuição Planilhas paralelas, números que não conversam entre si e gestores que fecham o mês sem entender o porquê dos resultados. É exatamente aqui que a inteligência artificial aplicada ao ERP Web Posseidom deixa de ser tendência e passa a ser infraestrutura de gestão. ⚙️ De ERP operacional para ERP cognitivo Um ERP tradicional responde perguntas como: Um ERP com IA aplicada à gestão, como o Posseidom, responde algo muito mais relevante: A IA não foi pensada como “recurso adicional”, mas como uma camada de inteligência sobre os dados já existentes, conectando áreas e revelando padrões invisíveis no dia a dia operacional. 🎯 O diferencial real: IA aplicada à gestão da informação (não ao hype) Muitas empresas falam de IA. Poucas sabem onde aplicá-la com impacto real. No Posseidom, o foco não é substituir pessoas — é ampliar a capacidade de leitura do negócio. 🔗 1. Consolidação inteligente de dados dispersos Empresas em crescimento sofrem com um problema clássico: A inteligência artificial atua conectando essas camadas: ➡️ O gestor deixa de procurar informação e passa a enxergar o negócio como um sistema único. 📈 2. Leitura automática de indicadores críticos Relatórios não faltam. O problema é saber onde olhar. A IA do Posseidom prioriza automaticamente: Isso reduz decisões baseadas em “sensação” e aumenta decisões baseadas em sinais objetivos e consistentes. ⚠️ 3. Antecipação de riscos operacionais e fiscais Para empresas maduras, uma frase é constante: “Não posso ser surpreendido.” A inteligência artificial ajuda exatamente nisso: ➡️ O ERP deixa de ser reativo e passa a ser preventivo. 💼 IA como aliada do financeiro (não como ameaça) Um erro comum é associar IA apenas à automação de tarefas. Na prática, o maior ganho está em qualidade de decisão. Para o financeiro e para a diretoria, isso significa: A IA do Posseidom funciona como um analista silencioso, observando padrões que normalmente passariam despercebidos. 🧩 O Posseidom como base de decisões, não apenas como registro Quando a inteligência artificial está integrada ao ERP: O papel do ERP muda completamente: Ele deixa de ser “onde se lança informação” e passa a ser onde se entende o negócio. ✅ Conclusão — O futuro da gestão não é trabalhar mais, é enxergar melhor Empresas que crescem sem inteligência sobre seus dados crescem no escuro. Empresas que usam IA de forma estratégica crescem com controle. O ERP Web Posseidom foi desenhado para esse segundo grupo: A integração da inteligência artificial na gestão do ERP Web Posseidom – DP Sistemas traz resultados significativos no aprimoramento da tomada de decisões. A IA atua como um parceiro estratégico, analisando informações de forma a identificar tendências e desvios que poderiam impactar a performance da empresa. Essa capacidade de análise preditiva garante que a gestão não se baseie apenas em dados históricos, mas sim em insights que orientam ações futuras. Assim, a inteligência artificial transforma o ERP em uma ferramenta essencial para a eficiência e eficácia na gestão empresarial.