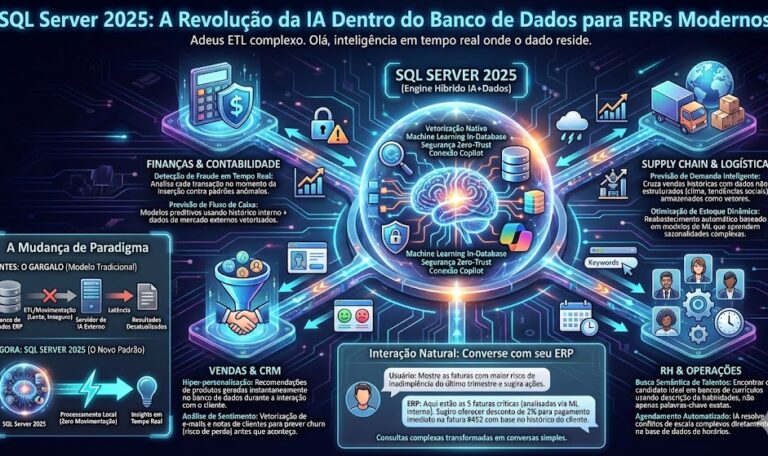

O Fim da Separação Entre Dados e Inteligência Artificial Imagine um mundo onde seu banco de dados compreende o significado das suas informações, não apenas a sequência de caracteres. Não é ficção científica. A partir de SQL Server 2025, agora é realidade para qualquer organização que execute C# .NET, Python ou qualquer linguagem que trabalhe com APIs REST. Durante anos, as arquiteturas de IA seguiram um padrão frustrante: os dados vivem no SQL Server; a inteligência artificial opera em sistemas separados como Pinecone, Weaviate ou Milvus; e você precisa manter sincronizados pipelines complexos de ETL, chamadas de API e infraestrutura duplicada. Essa separação criava problemas de latência, governança, segurança de dados e custo operacional. SQL Server 2025 quebra esse paradigma. Pela primeira vez, um banco de dados relacional empresarial integra nativamente capacidades de IA sem exigir sistemas externos. Vetores, embeddings, busca semântica e Retrieval-Augmented Generation (RAG) agora operam diretamente dentro do motor de dados, usando T-SQL familiar. Por Que Isso Importa Agora A transformação digital não é mais opcional. As organizações precisam de aplicações data-aware que compreendam contexto, não apenas dados estruturados. Mas há um problema: implementar IA em escala empresarial é complexo. A maioria dos desenvolvadores precisa escolher entre: SQL Server 2025 oferece uma terceira via: IA integrada, sem adicionar complexidade operacional. “Pela primeira vez, você pode implementar busca semântica, recomendações e RAG diretamente no T-SQL, sem manter sistemas vetoriais separados.” O Que Mudou: Os Pilares da IA em SQL Server 2025 1. Tipo de Dados VECTOR Nativo SQL Server agora reconhece VECTOR(n) como tipo de dado nativo, onde n representa as dimensões do embedding (tipicamente 1.536 para modelos OpenAI). sqlCREATE TABLE Documents ( DocumentId INT PRIMARY KEY, Content NVARCHAR(MAX), Embedding VECTOR(1536) — Novo tipo de dado nativo ); Antes, você tinha que armazenar embeddings como NVARCHAR ou VARBINARY, perdendo otimizações de índices e operações vetoriais. Agora, o banco de dados entende nativamente que você está trabalhando com embeddings. 2. Função VECTOR_DISTANCE: Busca Semântica em Milissegundos A nova função VECTOR_DISTANCE permite comparar vetores e calcular similaridade em microsegundos: sqlDECLARE @query_vector VECTOR(1536) = VECTOR_OF_EMBEDDING(‘…embedding_aqui…’); SELECT TOP 5 DocumentId, Content FROM Documents ORDER BY VECTOR_DISTANCE(Embedding, @query_vector) — Ordena por similaridade FETCH NEXT 5 ROWS ONLY; Isso substitui a necessidade de bancos vetoriais separados. DiskANN, o mesmo algoritmo usado pelo Bing Search, garante performance mesmo com bilhões de vetores. 3. RAG (Retrieval-Augmented Generation) Integrado em T-SQL RAG é a técnica que melhora drasticamente a precisão de LLMs ao fornecer contexto dos seus dados. Antes, você precisava: Agora, tudo acontece em uma consulta T-SQL unificada: sqlDECLARE @search_text NVARCHAR(MAX) = ‘Quais produtos vermelhos temos em estoque?’; DECLARE @search_vector VECTOR(1536); — Gera embedding do texto de busca EXEC sp_invoke_external_rest_endpoint @uri = ‘https://api.openai.com/v1/embeddings’, @payload = JSON_OBJECT(‘input’, @search_text), @method = ‘POST’, @output = @search_vector OUTPUT; — Busca similares e passa para LLM SELECT TOP 3 p.ProductId, p.Name, p.Description FROM Products p WHERE p.Color = ‘Red’ ORDER BY VECTOR_DISTANCE(p.Embedding, @search_vector); — LLM gera resposta baseada nos resultados acima Arquitetura Prática: Como Implementar com C# e .NET Para equipes usando a stack Posseidom (C# .NET, SQL Server), a integração é simplificada: csharpusing Microsoft.SemanticKernel; using Microsoft.EntityFrameworkCore; // 1. Configurar Semantic Kernel var builder = Kernel.CreateBuilder(); builder.Services.AddAzureOpenAIChatCompletion( “seu-resource”, “seu-endpoint”, “sua-chave”); var kernel = builder.Build(); // 2. Gerar embedding de uma query do usuário var userQuery = “Recomende produtos de IA para iniciantes”; var embeddings = await kernel.GetEmbeddingAsync(userQuery); // 3. Buscar documentos similares no SQL Server var similarProducts = await dbContext.Products .Where(p => EF.Functions.VariantVectorDistance( p.Embedding, embeddings) < 0.3) // Distância vetorial .ToListAsync(); // 4. RAG: Usar contexto para gerar resposta var context = string.Join(“\n”, similarProducts.Select(p => p.Description)); var result = await kernel.InvokeAsync( “GenerateRecommendation”, new { context, query = userQuery }); Console.WriteLine(result); O fluxo é limpo, performático e mantém dados seguros dentro do SQL Server. O Impacto Real: Casos de Uso Transformadores Chatbots Inteligentes Sobre Seus Dados Antes: O chatbot retorna informações genéricas ou erra ao não ter contexto atual. Agora: Usando RAG nativo, o chatbot recupera documentos relevantes do seu banco de dados em tempo real. sql– Query única que alimenta um chatbot empresarial SELECT TOP 5 Article.Title, Article.Content, VECTOR_DISTANCE(Article.Embedding, @user_question_vector) AS Relevance FROM KnowledgeBase Article ORDER BY Relevance FETCH FIRST 5 ROWS ONLY; Recomendação Semântica em Tempo Real E-commerce, streaming, redes sociais – todos ganham com recomendações que entendem intenção do usuário, não apenas palavras-chave. sql– Recomenda produtos semanticamente similares SELECT TOP 10 Product.*, VECTOR_DISTANCE(Product.Embedding, @current_product_embedding) AS Similarity FROM Products Product WHERE ProductCategoryId = @category ORDER BY Similarity Anomalia Detection com Contexto Detectar fraude, comportamento anômalo, ou insights ocultos agora considera padrões semânticos, não apenas dados brutos. Por Que Desenvolvedores Devem Se Importar Se você trabalha com C# .NET e MS SQL Server (como a maioria das aplicações enterprise), essa atualização é transformadora: Comparação: Antes vs. Depois Aspecto SQL Server 2024 SQL Server 2025 Armazenar Embeddings NVARCHAR/VARBINARY (sem otimização) VECTOR(n) nativo com índices Busca Semântica Impossível; apenas LIKE ou Full-Text VECTOR_DISTANCE em milissegundos RAG Requer sistema externo Integrado em T-SQL Integração com LLM Manual via aplicação sp_invoke_external_rest_endpoint Escalabilidade Problemática para bilhões de vetores DiskANN, escalável Infraestrutura Multiple systems One platform Tendência Maior: O Banco de Dados se Torna Plataforma SQL Server 2025 não está sozinho. Oracle, PostgreSQL e até SQLite estão adicionando capacidades vetoriais. Mas Microsoft tem vantagem: A tendência é clara: o banco de dados não será mais apenas um repositório – será a engine de IA da sua aplicação. Como Começar Reflexão Final Durante anos, IA em aplicações enterprise significava: mais infraestrutura, mais complexidade, mais especialistas. SQL Server 2025 muda isso. Agora, um desenvolvedor .NET com conhecimento básico de SQL pode construir aplicações data-aware, semanticamente inteligentes, seguras e escaláveis – tudo usando ferramentas que já conhece. Essa não é uma feature. É uma rearchitetura da relação entre dados e inteligência. A questão já não é “Como integro IA no meu sistema?” mas “Por que meu banco de dados ainda não faz isso nativamente?” SQL Server 2025 responde essa pergunta definitivamente.