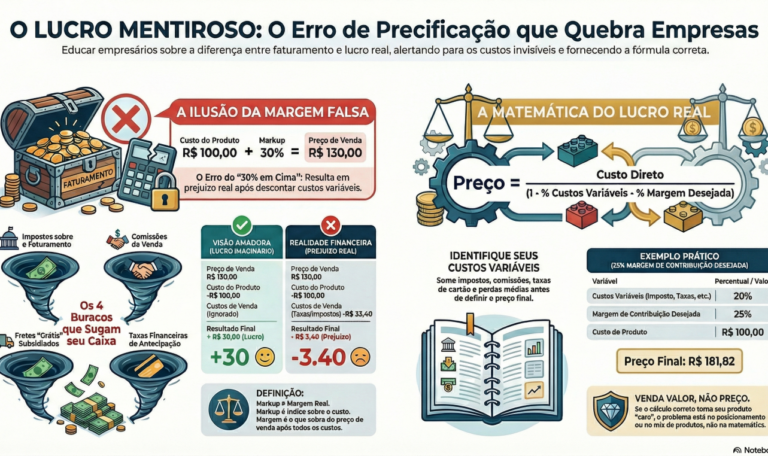

Gancho: Se você calcula preço assim, você pode estar lucrando menos sem perceber. Você olha o extrato, vê dinheiro entrando, paga as contas, fecha o mês e pensa: “estamos indo bem”. Só que aí vem a realidade: falta caixa, o estoque gira e mesmo assim a empresa parece sempre no limite. Você trabalha mais, vende mais, e a sensação é que a empresa não enriquece. A conta não fecha. Isso não é azar. É matemática mal feita. E tem um erro clássico, repetido em milhares de empresas, que cria a ilusão do lucro: precificar pelo “custo do produto” e ignorar o custo real de vender. O nome muda (markup, margem, “dobro do preço”, “30% em cima”), mas o resultado é o mesmo: margem falsa. Este artigo é para você que já passou da fase do improviso e quer gestão de verdade. Sem romantizar. Sem “achismo”. Só controle. ✅ O que você acha que é lucro… e o que lucro realmente é Vamos começar com uma frase que dói, mas te salva: Vender com preço errado é como dirigir com o painel quebrado: você acha que está tudo bem… até o motor fundir. O que muitos empresários chamam de “lucro” é só diferença entre preço de venda e custo do produto. Isso é no máximo margem bruta — e ainda assim, frequentemente calculada errado. Lucro real é o que sobra depois de pagar tudo o que existe para vender: Se você não coloca isso na conta, você está fazendo uma coisa bem específica:financiando o cliente com o seu patrimônio e chamando isso de venda. 🎯 O erro clássico: confundir “custo do produto” com “custo de vender” ❌ O cálculo errado (o mais comum) Só que você ignorou o óbvio: Total que “some”: R$ 33,40 Agora refaz a conta: Você vendeu. Trabalhou. Entregou. E pagou para o cliente levar. E o pior: como entra dinheiro, você não percebe na hora. Você só percebe quando o caixa aperta, quando o limite do banco aumenta, quando o estoque precisa ser reposto e você não tem capital. 📌 Esse é o “lucro mentiroso”. 🧨 Margem falsa: o veneno silencioso que mata empresa em crescimento Crescer com margem falsa é pior do que não crescer. Porque você amplia: …sem ampliar o lucro. Isso cria o cenário clássico: ✅ faturamento sobe✅ equipe aumenta✅ rotina fica mais pesada❌ caixa fica pior❌ dono vira bombeiro❌ empresa “cresce e empobrece” E o culpado quase sempre está na precificação. 🧩 Os 4 buracos por onde seu lucro vaza (e você finge que não vê) 1) Impostos: “depois eu vejo” Imposto não é surpresa. É regra do jogo.Se você precifica sem imposto, você está mentindo para si mesmo. Erro comum: calcular margem em cima do custo e esquecer que imposto incide sobre faturamento (preço de venda). 📌 Pergunta que dói:Você sabe seu percentual médio de impostos sobre venda, por regime e tipo de operação? Se a resposta é “mais ou menos”, você está precificando no escuro. 2) Comissão: “é pouco” Comissão é variável e cresce com vendas. E tem um detalhe:ela incide sobre venda, não sobre lucro. Se você paga 5% de comissão, isso já consome margem. Se paga 8% ou 10%, o estrago é maior. E se você tem metas agressivas, tende a empilhar comissão em cima de preço frágil. 📌 Pergunta objetiva:Sua comissão foi desenhada para incentivar venda… ou para destruir sua margem? 3) Frete: o “presente” que sai do seu bolso Frete é um dos maiores crimes de precificação. Você dá frete como se fosse marketing, mas ninguém mede se aquilo voltou como margem. 📌 Regra simples:Se frete não entra no cálculo, você está vendendo com prejuízo sem saber. 4) Taxas e prazos: o custo financeiro invisível Cartão e parcelamento não são neutros. Se você vende em 6x e antecipa, você está pagando juros.Se vende com prazo longo no boleto, você está financiando o cliente.Se tem inadimplência, você está doando margem. 📌 Pergunta que separa amador de gestor:Você precifica diferente à vista, no cartão, no boleto e no prazo? Se não, você está cobrindo o custo de quem paga devagar com o dinheiro de quem paga rápido — e chamando isso de “estratégia”. 🧠 A diferença entre “markup” e “margem”: onde quase todo mundo se engana Vou dizer sem delicadeza: a maioria usa markup errado. Markup (muita gente calcula assim) “Vou botar 30% em cima do custo.” Isso gera um preço, mas não garante margem real, porque os custos variáveis incidem sobre a venda. Margem (o que importa de verdade) Margem é o percentual do preço que sobra depois de custos. Já no markup: 📌 Se você mistura os dois, você pode achar que tem 30% e ter 10% ou 0%.É assim que empresa “lucrativa” quebra. ✅ Como calcular preço do jeito certo (modelo simples e robusto) Você não precisa de MBA. Precisa de um modelo que considere custos variáveis. Passo 1: Liste os custos variáveis (% do faturamento) Exemplo típico (ajuste para sua realidade): 📌 Esses 20% incidem sobre o preço de venda. Passo 2: Defina a margem de contribuição desejada Margem de contribuição é o que sobra para pagar despesas fixas e dar lucro. Exemplo: Passo 3: Calcule o “percentual que pode ser custo do produto” Se variáveis = 20% e margem desejada = 25%Então o produto + custo direto pode ser no máximo: 100% – 20% – 25% = 55% Ou seja: o custo total direto pode representar 55% do preço. Passo 4: Fórmula prática Preço de Venda = Custo Direto / (1 – Variáveis – Margem Desejada) Exemplo: Preço = 100 / (1 – 0,20 – 0,25)Preço = 100 / 0,55Preço = R$ 181,82 Agora compare com “100 + 30% = 130”. A diferença é brutal. E ela revela a verdade: 👉 ou você estava vendendo com prejuízo👉 ou sua empresa sobrevive porque tem outros produtos segurando o rombo👉 ou você compensa no grito, no volume, na exaustão e no limite bancário 🧱 “Mas se eu cobrar isso, eu não vendo” — ótimo, chegamos..